2022年11月,智能对话机器人模型ChatGPT上线,ChatGPT的连续对话能力、强大的理解力、回答的准确度和创造性使其迅速走红。短短两个月时间,用户数便突破1亿。ChatGPT等AIGC(AI-Generated Content,人工智能生产内容)模型的爆发式突破得益于生成算法、预训练模型、多模态技术等关键技术的落地。

ChatGPT火爆的背后是强大的算力支撑

OpenAI做GPT-3时,需要4000张卡做训练,GPT-4需要2万张卡做训练,现在是把1000万颗GPU连在一起训练新的模型。以英伟达上一款旗舰GPU A100来粗略估算,目前一张A100 40G的售价为6.3万元,OpenAI三个阶段光是GPU方面的训练成本,分别需要2.52亿元、12.6亿元和6300亿元。

随着各个巨头争相发布自己的AI大模型,AI服务器的市场需求也悄然陡增

AI服务器对于PCB需求按照价值量可以分为三部分:

1、GPU板组:布线密度高,传输速率高,发热量大,可靠性要求高。

2、CPU母版:主要负责GPU集群的管理和对外通信,与普通服务器要求基本一样。

3、电源板块、硬盘、风扇等外围模块:可靠性要求高,大功率。

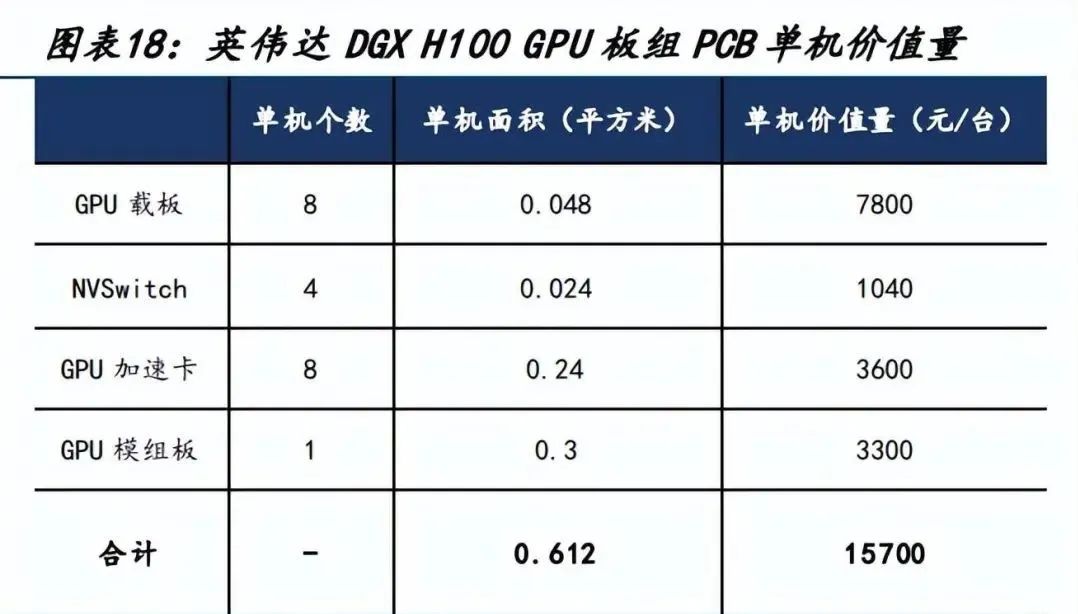

我们以英伟达标杆性产品 DGX H100 为 AI 服务器代表对 PCB 价值量进行计算。

GPU 板组(GPU Board Tray)

DGX H100 的 GPU 板组主要包括 GPU 载板、NVSwitch、OAM、UBB 四部分,合计 PCB 价值量 15700 元/台。其中:GPU 载板,根据产业链调研,单颗 PCB 价值量约为 150 美元,H100 包含 8 个 CPU 载板;

NVSwitch 的载体类似载板,根据产业链调研单颗价值量约 40 美元, H100 共搭载 4 颗;

OAM 中文简称 GPU 加速卡,H100 共搭载 8 个 OAM,根据产业链调研, 其预计为 5 阶 HDI,单价 15000 元/平方米,单价价值量将达到 3600 元;

UBB 中文简 称 GPU 模组板,用于搭载整个 GPU 平台,根据 DGX H100 底面规格和产业链调研,单价为 11000 元/平方米,UBB 单机 PCB 价值量为 3300 元。

CPU 母板

包含CPU 载板、CPU 主板和配板,其中功能性配板包括系统内存卡、网卡、拓展卡、存储操作系统驱动板,合计 PCB 价值量 3554 元/台。

其中:根据产业链调研,CPU 载板与 GPU 载板规格相近,DGX H100 搭载 2 颗 CPU,则单机价值量约为 1300 元;

估测 CPU 主板面积为 0.38 平方米,根据产业链调研数据,DGX H100 主板采 用 PCIe5.0 总线标准,单价约为 5000 元/平方米,计算 CPU 主板单机价值量为 1900 元;

配板种类较多,根据产业链调研,配板一般采用的规格是 8~10 层板,单价约为 1500 元/平方米,综合单机价值量约为 354 元。

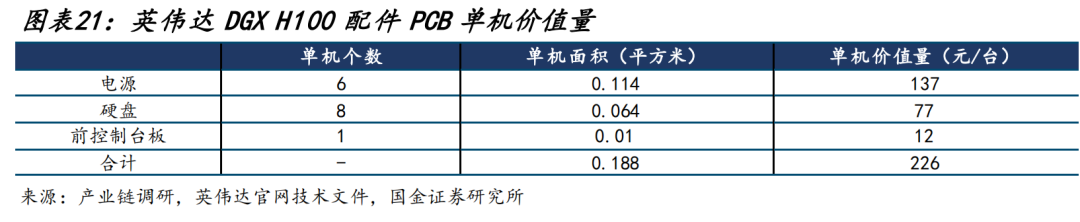

电源、硬盘及配件

单机价值量合计 226 元。配件的单价约为 1000~1500 元/平方米不等,主要包括 6 个电源,单个PCB面积为 0.019 平方米,硬盘 8个,单块硬盘中 PCB 面积为 0.008 平方米,前控制台板 1 块面积约为 0.010 平方米。

综合 GPU 板组、CPU 模板组和配件三大板块,我们估测 DGX H100 整机 PCB 用量面积为 1.428 平方米,单机 PCB 价值量为 19520 元。

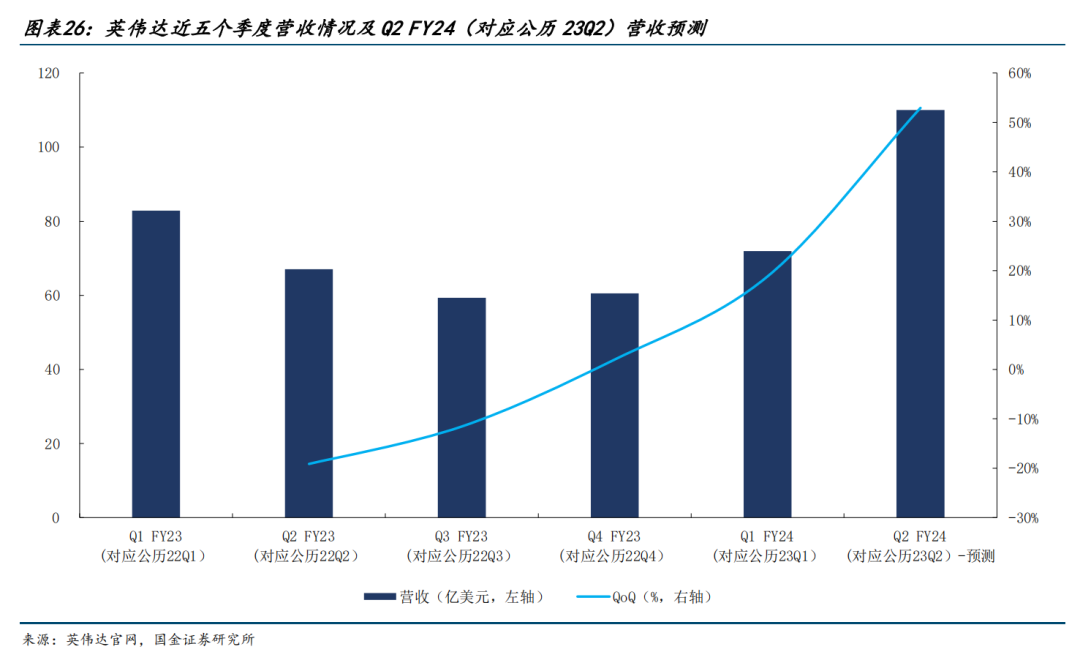

AI 服务器已到加速发展阶段

从英伟达的业绩跟踪情况来看,英伟达数据中心业务营收快速增长,23Q1 实现同比+14%、环比+18%,并且英伟达给出明确指引提到 23Q2 因数据中心业务而总体营收环比有望实现 53%的增长,可以预见AI服务器将迎来快速增长期。

AI 服务器需求将推动服务器相关 PCB 业务发展

AI 服务器单机 PCB 价值量 19520 元相较普通服务器单机 PCB 价值量 2425 元增长 705%,在 AI 服务器快速增长的情况下,PCB 行业也将迎来扩容。

根据 IDC 数据及预测,全球 GPU 服务器在 2022~2025 年分别出货 319 万只、364 万只、 412 万只、463 万只,根据产业链调研情况可知 2022 年训练 GPU 出货占比达到 25%, 考虑到云计算厂商推出的大模型数量快速增长、云计算厂商对训练算力的需求将在近年快速升温,因此我们假设训练端 GPU 占服务器 GPU 出货量比例在 2023~2025 年达到 35%、40%、40%,对应训练 GPU 出货量为 127 万只、165 万只、185 万只,相应推理 GPU 出货量为 237 万只、247 万只、278 万只。

英伟达作为 AI 服务器 GPU 的主要方案设计者,其训练服务器和推理服务器的标准设计均采用 8 卡方案,因此我们按照 8 卡为 1 台服务器进行测算,则对应 AI 服务器出货量为 46 万台、52 万台、58 万台,其中 AI 训练服务器出货量为 16 万 台、21 万台、23 万台,AI 推理服务器出货量为 30 万台、31 万台、35 万台。

按照前述测算,AI 训练服务器单机 PCB 价值量为 19520 元、AI 推理服务器单机 PCB 价值量为 9760 元,结合服务器出货量,对应 AI 服务器所用 PCB 市场规模在 2023~2025 年将达到 60 亿元、70 亿元和 79 亿元,同比增速为 23%、17%、12%。

文章引用来源:AI带来PCB增量,强α者率先受益-国金证券[樊志远,邓小路,刘妍雪]

注:以上内容整理自网络,版权归原作者所有,如有侵权,请联系删除。

官方微信

官方微信